Divisione di supercalcolo avanzato della NASA - NASA Advanced Supercomputing Division

| |

| Panoramica dell'agenzia | |

|---|---|

| formato | 1982 |

| Agenzie precedenti | |

| Sede centrale |

NASA Ames Research Center , Moffett Field , California 37 ° 25'16 "N 122 ° 03'53" W / 37.42111°N 122.06472°W |

| Dirigente dell'agenzia | |

| Dipartimento genitori | Direzione della tecnologia di esplorazione del centro di ricerca di Ames |

| Agenzia madre | Amministrazione nazionale dell'aeronautica e dello spazio (NASA) |

| Sito web | www |

| Attuali sistemi di supercalcolo | |

| Pleiadi | Superammasso SGI/HPE ICE X |

| Aitken | Sistema HPE E-Cell |

| Elettra | Sistema SGI/HPE ICE X e HPE E-Cell |

| Tentativo | Sistema di memoria condivisa SGI UV |

| Merope | Superammasso SGI Altix |

La divisione NASA Advanced Supercomputing (NAS) si trova presso il NASA Ames Research Center , Moffett Field, nel cuore della Silicon Valley a Mountain View , California . È stata la principale risorsa di supercalcolo, modellazione e simulazione per le missioni della NASA in aerodinamica, esplorazione dello spazio, studi sui modelli meteorologici e sulle correnti oceaniche e progettazione e sviluppo di navicelle spaziali e velivoli per quasi quarant'anni.

La struttura attualmente ospita la petascale Pleiadi , Aitken e Electra supercomputer , così come il terascala Endeavour supercomputer. I sistemi sono basati su architettura SGI e HPE con processori Intel . L'edificio principale ospita anche sistemi di archiviazione su disco e su nastro di archiviazione con una capacità di oltre un exabyte di dati, il sistema di visualizzazione hyperwall e uno dei più grandi fabric di rete InfiniBand al mondo. La divisione NAS fa parte dell'Exploration Technology Directorate della NASA e gestisce il progetto High-End Computing Capability (HECC) della NASA.

Storia

Fondazione

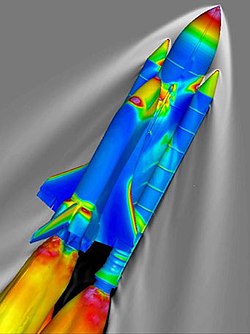

A metà degli anni '70, un gruppo di ingegneri aerospaziali presso l'Ames Research Center ha iniziato a esaminare il trasferimento della ricerca e dello sviluppo aerospaziale da test in galleria del vento costosi e dispendiosi in termini di tempo a progettazione e ingegneria basate sulla simulazione utilizzando modelli di fluidodinamica computazionale (CFD) su supercomputer più potenti di quelli disponibili in commercio all'epoca. Questo sforzo fu in seguito chiamato Progetto Numerical Aerodynamic Simulator (NAS) e il primo computer fu installato presso la Central Computing Facility presso l'Ames Research Center nel 1984.

Il 14 marzo 1985 ebbe luogo l'inaugurazione di una struttura di supercalcolo all'avanguardia per costruire un edificio in cui esperti CFD, scienziati informatici, specialisti di visualizzazione e ingegneri di rete e storage potessero essere sotto lo stesso tetto in un ambiente collaborativo. Nel 1986, il NAS è passato a una divisione della NASA a tutti gli effetti e nel 1987 il personale e le apparecchiature NAS, incluso un secondo supercomputer, un Cray-2 chiamato Navier, sono stati trasferiti nella nuova struttura, che è stata dedicata il 9 marzo 1987.

Nel 1995, NAS ha cambiato il suo nome in Numerical Aerospace Simulation Division e nel 2001 nel nome che ha oggi.

Innovazioni leader del settore

Il NAS è stato uno dei principali innovatori nel mondo del supercalcolo, sviluppando molti strumenti e processi che sono stati ampiamente utilizzati nel supercalcolo commerciale. Alcuni di questi primi includono:

- Installato il primo supercomputer basato su UNIX di Cray

- Implementato un modello client/server che collega i supercomputer e le workstation insieme per distribuire il calcolo e la visualizzazione

- Sviluppato e implementato una rete WAN ( Wide Area Network ) ad alta velocità che collega le risorse di supercalcolo agli utenti remoti (AEROnet)

- Co-sviluppato il primo metodo della NASA per la distribuzione dinamica dei carichi di produzione attraverso risorse di supercalcolo in luoghi geograficamente distanti (NASA Metacenter)

- Rete TCP/IP implementata in un ambiente di supercalcolo

- Sviluppato un sistema di accodamento batch per supercomputer (NQS)

- Sviluppato un sistema di archiviazione di massa gerarchico basato su UNIX (NAStore)

- Co-sviluppato (con SGI) i primi supercomputer IRIX a singolo sistema di immagine con 256, 512 e 1.024 processori

- Co-sviluppato (con SGI) i primi supercomputer a sistema singolo basati su Linux con 512 e 1.024 processori

- Un ambiente di memoria condivisa con 2.048 processori

Sviluppo software

Il NAS sviluppa e adatta software per "integrare e migliorare il lavoro svolto sui suoi supercomputer, compreso il software per il supporto dei sistemi, i sistemi di monitoraggio, la sicurezza e la visualizzazione scientifica" e spesso fornisce questo software ai suoi utenti attraverso l'accordo open source della NASA ( NOSA).

Alcuni degli importanti sviluppi software del NAS includono:

- NAS Parallel Benchmarks (NPB) sono stati sviluppati per valutare supercomputer altamente paralleli e imitare le caratteristiche delle applicazioni CFD su larga scala.

- Portable Batch System (PBS) è stato il primo software di accodamento batch per sistemi paralleli e distribuiti. È stato rilasciato commercialmente nel 1998 ed è ancora ampiamente utilizzato nel settore.

- PLOT3D è stato creato nel 1982 ed è un programma di computer grafica utilizzato ancora oggi per visualizzare le griglie e le soluzioni di dataset CFD strutturati. Il team PLOT3D ha ricevuto il quarto premio più grande mai assegnato dal NASA Space Act Program per lo sviluppo del proprio software, che ha rivoluzionato la visualizzazione scientifica e l'analisi delle soluzioni CFD 3D.

- FAST (Flow Analysis Software Toolkit) è un ambiente software basato su PLOT3D e utilizzato per analizzare i dati da simulazioni numeriche che, sebbene adattato alla visualizzazione CFD, può essere utilizzato per visualizzare quasi tutti i dati scalari e vettoriali . È stato insignito del premio NASA Software of the Year nel 1995.

- INS2D e INS3D sono codici sviluppati da ingegneri NAS per risolvere equazioni di Navier-Stokes incomprimibili in coordinate generalizzate bidimensionali e tridimensionali, rispettivamente, per flusso stazionario e variabile nel tempo. Nel 1994, INS3D ha vinto il premio NASA Software of the Year.

- Cart3D è un pacchetto di analisi ad alta fedeltà per la progettazione aerodinamica che consente agli utenti di eseguire simulazioni CFD automatizzate su moduli complessi. È ancora utilizzato dalla NASA e da altre agenzie governative per testare progetti concettuali e preliminari di veicoli aerei e spaziali. Il team Cart3D ha vinto il premio NASA Software of the Year nel 2002.

- OVERFLOW (Overset grid flow solver) è un pacchetto software sviluppato per simulare il flusso di fluidi attorno a corpi solidi utilizzando equazioni CFD di Navier-Stokes mediate da Reynolds. È stato il primo codice CFD della NASA generico per i sistemi a griglia overset (Chimera) ed è stato rilasciato al di fuori della NASA nel 1992.

- Chimera Grid Tools (CGT) è un pacchetto software contenente una varietà di strumenti per l'approccio a griglia overset di Chimera per risolvere problemi CFD di generazione di griglia di superficie e volume; così come la manipolazione della griglia, il livellamento e la proiezione.

- HiMAP Un Processo di Analisi Multidisciplinare (Fluidi, Strutture, Controlli) parallelo ad alta fedeltà a tre livelli (Intra/Inter, multicaso),

Storia del supercalcolo

Dalla sua costruzione nel 1987, la NASA Advanced Supercomputing Facility ha ospitato e gestito alcuni dei più potenti supercomputer del mondo. Molti di questi computer includono sistemi di testbed costruiti per testare nuove architetture, hardware o configurazioni di rete che potrebbero essere utilizzate su scala più ampia. Le prestazioni di picco sono mostrate in Operazioni in virgola mobile al secondo (FLOPS) .

| Nome del computer | Architettura | Massime prestazioni | Numero di CPU | Data di installazione |

|---|---|---|---|---|

| Cray XMP-12 | 210,53 megaflop | 1 | 1984 | |

| Navier | Cray 2 | 1,95 gigaflop | 4 | 1985 |

| Mandrino | Convesso 3820 | 1,9 gigaflop | 8 | 1987 |

| Pierre | Macchine pensanti CM2 | 14.34 gigaflop | 16.000 | 1987 |

| 43 gigaflop | 48.000 | 1991 | ||

| Stokes | Cray 2 | 1,95 gigaflop | 4 | 1988 |

| Pifferaio | CDC/ETA-10Q | 840 megaflop | 4 | 1988 |

| Reynolds | Cray Y-MP | 2,54 gigaflop | 8 | 1988 |

| 2,67 gigaflop | 88 | 1988 | ||

| Lagrange | Intel iPSC/860 | 7,88 gigaflop | 128 | 1990 |

| Gamma | Intel iPSC/860 | 7,68 gigaflop | 128 | 1990 |

| von Karman | Convesso 3240 | 200 megaflop | 4 | 1991 |

| Boltzmann | Macchine pensanti CM5 | 16.38 gigaflop | 128 | 1993 |

| Sigma | Intel Paragon | 15,60 gigaflop | 208 | 1993 |

| von Neumann | Cray C90 | 15.36 gigaflop | 16 | 1993 |

| Aquila | Cray C90 | 7,68 gigaflop | 8 | 1993 |

| adornare | Intel Paragon | 15,6 gigaflop | 209 | 1993 |

| babbeo | IBM SP-2 | 34.05 gigaflop | 128 | 1994 |

| 42.56 gigaflop | 160 | 1994 | ||

| da Vinci | SGI Power Challenge | 16 | 1994 | |

| SGI Power Challenge XL | 11.52 gigaflop | 32 | 1995 | |

| Newton | Cray J90 | 7.2 gigaflop | 36 | 1996 |

| maialino | Origine SGI 2000/250 MHz | 4 gigaflop | 8 | 1997 |

| Turing | Origine SGI 2000/195 MHz | 9.36 gigaflop | 24 | 1997 |

| 25 gigaflop | 64 | 1997 | ||

| Fermi | Origine SGI 2000/195 MHz | 3.12 gigaflop | 8 | 1997 |

| tramoggia | Origine SGI 2000/250 MHz | 32 gigaflop | 64 | 1997 |

| Evelyn | Origine SGI 2000/250 MHz | 4 gigaflop | 8 | 1997 |

| Steger | Origine SGI 2000/250 MHz | 64 gigaflop | 128 | 1997 |

| 128 gigaflop | 256 | 1998 | ||

| Lomax | Origine SGI 2800/300 MHz | 307,2 gigaflop | 512 | 1999 |

| 409.6 gigaflop | 512 | 2000 | ||

| Lou | Origine SGI 2000/250 MHz | 4.68 gigaflop | 12 | 1999 |

| Ariel | Origine SGI 2000/250 MHz | 4 gigaflop | 8 | 2000 |

| Sebastian | Origine SGI 2000/250 MHz | 4 gigaflop | 8 | 2000 |

| SN1-512 | Origine SGI 3000/400 MHz | 409.6 gigaflop | 512 | 2001 |

| Luminoso | Cray SVe1/500 MHz | 64 gigaflop | 32 | 2001 |

| Chapman | Origine SGI 3800/400 MHz | 819.2 gigaflop | 1.024 | 2001 |

| 1.23 teraflop | 1.024 | 2002 | ||

| Lomax II | Origine SGI 3800/400 MHz | 409.6 gigaflop | 512 | 2002 |

| Kalpana | SGI Altix 3000 | 2,66 teraflop | 512 | 2003 |

| Cray X1 | 204.8 gigaflop | 2004 | ||

| Colombia | SGI Altix 3000 | 63 teraflop | 10.240 | 2004 |

| SGI Altix 4700 | 10,296 | 2006 | ||

| 85,8 teraflop | 13.824 | 2007 | ||

| Schirra | IBM POWER5+ | 4.8 teraflop | 640 | 2007 |

| RT Jones | SGI ICE 8200 , Processori Intel Xeon "Harpertown" | 43,5 teraflop | 4.096 | 2007 |

| Pleiadi | SGI ICE 8200, Processori Intel Xeon "Harpertown" | 487 teraflop | 51.200 | 2008 |

| 544 teraflop | 56,320 | 2009 | ||

| SGI ICE 8200, Intel Xeon "Harpertown" / "Nehalem" Processori | 773 teraflop | 81.920 | 2010 | |

| SGI ICE 8200/8400, Intel Xeon "Harpertown" / "Nehalem" / "Westmere" Processori | 1,09 petaflop | 111,104 | 2011 | |

| SGI ICE 8200/8400 / X, Intel Xeon "Harpertown" / "Nehalem" / "Westmere" / "Sandy Bridge" Processori | 1.24 petaflop | 125,980 | 2012 | |

| SGI ICE 8200/8400 / X, Intel Xeon "Nehalem" / "Westmere" / "Sandy Bridge" / "Ivy Bridge" Processori | 2.87 petaflop | 162.496 | 2013 | |

| 3.59 petaflop | 184,800 | 2014 | ||

| SGI ICE 8400 / X, Intel Xeon "Westmere" / "Sandy Bridge" / "Ivy Bridge" / "Haswell" Processori | 4.49 petaflop | 198.432 | 2014 | |

| 5.35 petaflop | 210,336 | 2015 | ||

| SGI ICE X, Intel Xeon "Sandy Bridge" / "Ivy Bridge" / "Haswell" / "Broadwell" Processori | 7.25 petaflop | 246.048 | 2016 | |

| Tentativo | SGI UV 2000 , processori Intel Xeon "Sandy Bridge" | 32 teraflop | 1.536 | 2013 |

| Merope | SGI ICE 8200, Processori Intel Xeon "Harpertown" | 61 teraflop | 5.120 | 2013 |

| SGI ICE 8400, processori Intel Xeon "Nehalem"/"Westmere" | 141 teraflop | 1,152 | 2014 | |

| Elettra | SGI ICE X, processori Intel Xeon "Broadwell" | 1,9 petaflop | 1,152 | 2016 |

| SGI ICE X / HPE SGI 8600 E-Cell, processore Intel Xeon "Broadwell" / "Skylake" Processori | 4.79 petaflop | 2.304 | 2017 | |

| 8.32 petaflop | 3,456 | 2018 | ||

| Aitken | HPE SGI 8600 E-Cell, processore Intel Xeon "Cascade Lake" Processori | 3.69 petaflop | 1.150 | 2019 |

| Nome del computer | Architettura | Massime prestazioni | Numero di CPU | Data di installazione |

Risorse di archiviazione

Archiviazione su disco

Nel 1987, NAS ha collaborato con la Defense Advanced Research Projects Agency (DARPA) e l' Università della California, Berkeley nel progetto RAID ( Redundant Array of Inexpensive Disks ), che ha cercato di creare una tecnologia di archiviazione che combinasse più componenti dell'unità disco in un'unica logica unità. Completato nel 1992, il progetto RAID ha portato alla tecnologia di archiviazione dati distribuita utilizzata oggi.

La struttura NAS attualmente ospita l'archiviazione di massa su disco su un cluster DMF parallelo SGI con software ad alta disponibilità costituito da quattro sistemi front-end a 32 processori, collegati ai supercomputer e al sistema di archiviazione su nastro di archiviazione. Il sistema ha 192 GB di memoria per front-end e 7,6 petabyte (PB) di cache del disco. I dati archiviati su disco vengono regolarmente migrati ai sistemi di archiviazione di archiviazione su nastro presso la struttura per liberare spazio per altri progetti utente in esecuzione sui supercomputer.

Archivi e sistemi di archiviazione

Nel 1987, NAS ha sviluppato il primo sistema di archiviazione di massa gerarchico basato su UNIX, denominato NAStore. Conteneva due robot a nastro a cartuccia StorageTek 4400, ciascuno con una capacità di archiviazione di circa 1,1 terabyte, riducendo il tempo di recupero del nastro da 4 minuti a 15 secondi.

Con l'installazione del supercomputer Pleiades nel 2008, i sistemi StorageTek che il NAS utilizzava da 20 anni non erano in grado di soddisfare le esigenze del maggior numero di utenti e delle dimensioni dei file crescenti dei set di dati di ciascun progetto . Nel 2009, NAS ha introdotto i sistemi a nastro robotico Spectra Logic T950 che hanno aumentato la capacità massima della struttura a 16 petabyte di spazio disponibile per gli utenti per archiviare i propri dati dai supercomputer. A partire da marzo 2019, la struttura NAS ha aumentato la capacità di archiviazione totale di archiviazione delle librerie a nastro Spectra Logic a 1.048 petabyte (o 1 exabyte) con una compressione del 35%. Data Migration Facility (DMF) di SGI e OpenVault gestiscono la migrazione dei dati da disco a nastro e la demigrazione da nastro a disco per la struttura NAS.

A partire da marzo 2019, nel sistema di archiviazione di archiviazione NAS sono archiviati oltre 110 petabyte di dati univoci.

Sistemi di visualizzazione dei dati

Nel 1984, NAS ha acquistato 25 terminali grafici SGI IRIS 1000, l'inizio della loro lunga collaborazione con l'azienda con sede nella Silicon Valley, che ha avuto un impatto significativo sulla post-elaborazione e sulla visualizzazione dei risultati CFD eseguiti sui supercomputer della struttura. La visualizzazione è diventata un processo chiave nell'analisi dei dati di simulazione eseguiti sui supercomputer, consentendo a ingegneri e scienziati di visualizzare i loro risultati nello spazio e in modi che hanno consentito una maggiore comprensione delle forze CFD all'opera nei loro progetti.

L'ipermuro

Nel 2002, gli esperti di visualizzazione NAS hanno sviluppato un sistema di visualizzazione chiamato "hyperwall" che includeva 49 pannelli LCD collegati che consentivano agli scienziati di visualizzare set di dati complessi su un ampio e dinamico array di schermi sette per sette. Ogni schermo aveva la propria potenza di elaborazione, consentendo a ciascuno di visualizzare, elaborare e condividere set di dati in modo che una singola immagine potesse essere visualizzata su tutti gli schermi o configurata in modo che i dati potessero essere visualizzati in "celle" come un gigantesco foglio di calcolo visivo.

La seconda generazione "hyperwall-2" è stata sviluppata nel 2008 da NAS in collaborazione con Colfax International ed è composta da 128 schermi LCD disposti in una griglia 8x16 di 23 piedi di larghezza per 10 piedi di altezza. È in grado di riprodurre un quarto di miliardo di pixel , il che lo rende il sistema di visualizzazione scientifica con la più alta risoluzione al mondo. Contiene 128 nodi, ciascuno con due processori quad-core AMD Opteron ( Barcellona ) e un'unità di elaborazione grafica (GPU) Nvidia GeForce 480 GTX per una potenza di elaborazione di picco dedicata di 128 teraflop sull'intero sistema, 100 volte più potente dell'originale ipermuro. L'hyperwall-2 è collegato direttamente al filesystem del supercomputer Pleiades su una rete InfiniBand, che consente al sistema di leggere i dati direttamente dal filesystem senza dover copiare i file nella memoria dell'hyperwall-2.

Nel 2014, l'hyperwall è stato aggiornato con nuovo hardware: 256 processori Intel Xeon "Ivy Bridge" e 128 GPU NVIDIA Geforce 780 Ti. L'aggiornamento ha aumentato la potenza di elaborazione di picco del sistema da 9 teraflop a 57 teraflop e ora dispone di quasi 400 gigabyte di memoria grafica.

Nel 2020, l'hyperwall è stato ulteriormente aggiornato con nuovo hardware: 256 processori Intel Xeon Platinum 8268 (Cascade Lake) e 128 GPU NVIDIA Quadro RTX 6000 con un totale di 3,1 terabyte di memoria grafica. L'aggiornamento ha aumentato la potenza di elaborazione di picco del sistema da 57 teraflop a 512 teraflop.

Visualizzazione simultanea

Una caratteristica importante della tecnologia hyperwall sviluppata al NAS è che consente la "visualizzazione simultanea" dei dati, che consente a scienziati e ingegneri di analizzare e interpretare i dati mentre i calcoli sono in esecuzione sui supercomputer. Questo non solo mostra lo stato attuale del calcolo per il monitoraggio del runtime, il governo e la terminazione, ma "consente anche una visualizzazione a risoluzione temporale più elevata rispetto alla post-elaborazione perché i requisiti di I/O e spazio di archiviazione sono ampiamente superati... [e ] può mostrare caratteristiche in una simulazione che altrimenti non sarebbero visibili."

Il team di visualizzazione NAS ha sviluppato una pipeline simultanea configurabile da utilizzare con un modello di previsione massicciamente parallelo eseguito sul supercomputer Columbia nel 2005 per aiutare a prevedere la stagione degli uragani atlantici per il National Hurricane Center . A causa delle scadenze per l'invio di ciascuna previsione, era importante che il processo di visualizzazione non ostacolasse in modo significativo la simulazione o ne causasse il fallimento.

Riferimenti

link esterno

Risorse di supercalcolo avanzate della NASA

- Homepage della divisione Advanced Supercomputing (NAS) della NASA

- Home page dell'ambiente di elaborazione NAS

- NAS Pleiades Supercomputer homepage

- Homepage del supercomputer NAS Aitken

- Homepage del Supercomputer NAS Electra

- Homepage dei sistemi di archiviazione e archiviazione NAS

- Home page NAS hyperwall-2